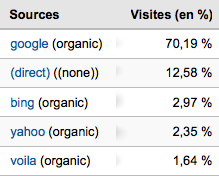

Un peu de concrêt pour commencer :

ça, c’est la répartition des recherches sur un site avec pas mal d’audience.

Donc, Bing, c’est déjà 3% du trafic.

Maintenant, quels sont les leviers de Microsoft pour monter en puissance ?

Jusqu’ici, Microsoft utilisait bien souvent Windows comme levier, en installant Internet Explorer et le moteur de recherche maison par défaut lors de l’installation de l’OS.

Si j’ai bien suivi, ça ne devrait plus être le cas avec Windows 7.

Il va donc falloir se différentier sur le fond : sur le service.

Bing va donc essayer de se battre de front avec Google, et proposer un meilleur service.

J’étais invité il y a quelques jours à l’évènement qu’organise Ciao pour ces meilleurs clients.

J’ai ainsi pu avoir une présentation « avancée » de Bing, par l’un des responsable de la R&D côté europe : Jordi Ribas.

L’un des axes de recherche de Microsoft, c’est de permettre aux internautes d’aller plus vite vers la bonne page.

Pour faire ça, Bing propose plusieurs axes :

Bon, déjà, pour « jouer », il faut configurer Bing en mode « USA », version actuellement bien plus avancée que notre version locale.

L’élément clé, c’est la colonne de gauche, qui permet, comme sur de plus en plus de sites marchands, d’affiner la recherche.

Cette colonne est alimenter de manière semi automatique : avec des programmes et un brin d’intervention humaine.

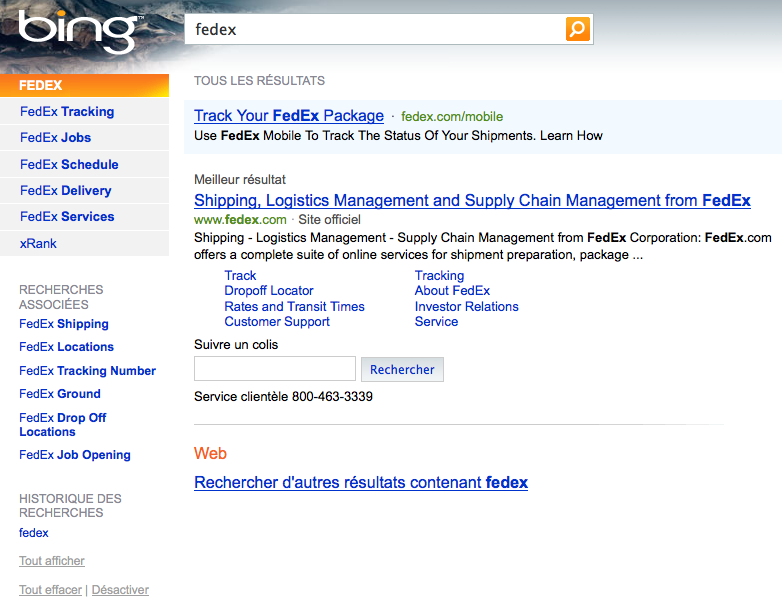

Autre élément : Microsoft essaye de pousser plus d’infos directement exploitable par l’internaute.

Ici, pour Fedex, on peut directement faire le tracking d’un colis.

Sur d’autres recherches, Bing propose directement les résultats sportifs, …

Autre nouveauté : le mode « preview ».

Avant de cliquer sur un lien, on peut voir un « résumé » de la page cible.

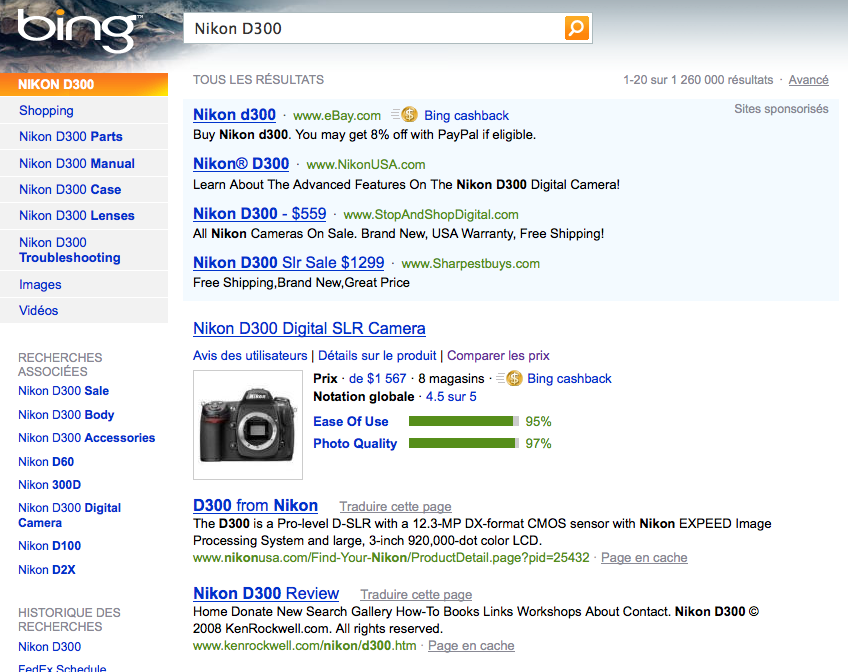

Enfin, quand ce qui est cherché est probablement un produit, Bing propose directement des informations de type « moteur de shopping » :

En synthèse

Est-ce que ces axes permettront à Microsoft de réellement ébranler la suprématie Google ?

Est-ce une tendance de fond, que d’intégrer le moteur de recherche avec le moteur de shopping ?

Google pourrait aussi avancer dans cette direction…

C’est un axe à double tranchant pour ces acteurs : vous imaginez, au bout de quelques temps, quand la page d’accueil de ces moteurs sera entièrement remplie par des liens vers des services maison ?

L’anti-trust ne serait sans doute pas très loin…

Autre point clé : finalement, la domination Google est très intéressante pour le SEO : il « suffit » de travailler son référencement par rapport à un seul acteur.

Vous imaginez si le marché se morcelle ? Vous faite une modification, et hop, vous montez d’un côté et descendez de l’autre… L’enfer !